Diese Fehler sollten Sie beim A/B-Testing vermeiden

Wollen Sie die Wirkung bestimmter Veränderungen an einer Kampagne messen, sind A/B-Tests das Werkzeug der Wahl. Fehler bei der Durchführung können allerdings zu falschen Rückschlüssen führen – in diesem Artikel erfahren Sie, worauf Sie beim A/B-Testing achten müssen und wie Sie die häufigsten Fehler vermeiden.

Im Marketing geht es darum, Verbraucher von bestimmten Marken, Produkten oder Dienstleistungen zu überzeugen. Im Vorfeld einer Kampagne lässt sich aufgrund der vielen Einflussfaktoren aber nicht sagen, ob die Werbebotschaft bereits perfekt auf die Zielgruppe ausgerichtet ist, oder ob es möglicherweise noch Verbesserungspotential gibt. Dementsprechend sollte ein Element fest zu jeder Kampagne gehören: das Testing. Insbesondere das A/B-Testing hat sich im Marketing bewährt, allerdings gibt es bei dieser Methode einige Stolpersteine, die Sie umgehen sollten, um ein aussagekräftiges Ergebnis zu erhalten. Wir haben daher für Sie die häufigsten Fehler beim A/B-Testing zusammengestellt, damit Sie diese vermeiden.

Was ist A/B-Testing und wo wird es verwendet?

Bevor wir aber näher auf die möglichen Fehlerquellen eingehen, sollten wir uns zunächst einmal ansehen, was A/B-Testing genau ist und in welchen Situationen solche Tests sinnvoll sind.

Ganz allgemein werden beim A/B-Testing zwei Varianten einer Kampagne erstellt, die sich lediglich in einem Punkt unterscheiden. Diese Varianten werden dann zeitgleich verwendet, wobei die Zielgruppe in zwei Hälften unterteilt wird, die jeweils nur eine der beiden Varianten zu sehen bekommen. Meist werden die Kunden dabei zufällig einer der beiden Gruppen zugeteilt, da bei einer bewussten Auswahl das Ergebnis verfälscht werden könnte. Zudem sollte im Vorfeld des Tests eine Hypothese aufgestellt werden, die mit dem Test dann entweder bestätigt oder widerlegt werden kann.

Sind die beiden Varianten erstellt, werden die Reaktionen der Kunden erfasst, sodass sich leicht feststellen lässt, welche der beiden Varianten eher zur gewünschten Reaktion führt. A/B-Testing lässt sich also überall dort verwenden, wo verschiedene Möglichkeiten oder Optionen auf ihre Wirksamkeit überprüft werden sollen. Mit einem solchen Test lässt sich aber zum Beispiel keine Aussage über die allgemeine Effektivität einer Kampagne treffen. Wollen Sie mehr über die Funktionsweise von A/B-Tests erfahren, empfehlen wir Ihnen unseren Artikel zu diesem Thema.

Wieso sind Fehler beim A/B-Testing so gefährlich?

An sich klingen A/B-Tests nicht sonderlich kompliziert, daher fragen Sie sich vielleicht, wie schlimm ein kleiner Fehler denn schon sein kann. In der Naturwissenschaft gibt es doch auch immer wieder Messabweichungen, die bei der Auswertung sogar fest eingeplant sind.

Leider sind Fehler beim A/B-Testing aber weit mehr als nur eine kleine Messabweichung, denn sie können das gesamte Ergebnis des Tests verfälschen und im schlimmsten Fall die Kampagne zunichtemachen. Falsche Ergebnisse sind nämlich nicht nur lästig, sie können zu völlig falschen Schlussfolgerungen führen. Nehmen wir dazu folgendes Testszenario: Sie wollen die Gestaltung des Kaufen-Buttons in Ihrem Webshop testen. Bei einer Testvariante ist der Button jedoch aufgrund eines technischen Fehlers kaum zu erkennen und schneidet entsprechend im Testing deutlich schlechter ab, als die Variante mit gut sichtbarem Button. Ein solcher Fehler kann dazu führen, dass der gut erkennbare Button als deutlich wirksamer beurteilt wird, obwohl er das vielleicht gar nicht ist. Das ist natürlich nur ein Beispiel für einen handwerklichen Fehler, aber systemische Fehler haben ganz ähnliche und oft sogar noch drastischere Auswirkungen.

Achten Sie bei A/B-Tests also unbedingt auf eine saubere Durchführung, denn nur so werden Sie verlässliche und aussagekräftige Ergebnisse erhalten, von denen Sie langfristig profitieren und auf deren Basis Sie weitere Massnahmen planen können.

Welche Fehler sind beim A/B-Testing möglich?

Ein sehr häufiger Fehler ist die falsche Durchführung des Tests – um das A/B-Testing sinnvoll einsetzen zu können, dürfen Sie nicht mehrere Tests zeitgleich durchführen, zudem darf der Testzeitraum nicht zu lang oder zu kurz sein und die Varianten müssen zur selben Zeit getestet werden.

Laufen mehrere Tests parallel, lässt sich nicht einwandfrei nachvollziehen, welche Änderung tatsächlich zur veränderten Reaktion der Kunden geführt hat, was die Aussagekraft des Tests vollkommen negiert. Ähnlich sieht es bei zwei unterschiedlichen Testzeiträumen für die beiden Varianten aus – durch veränderte Testbedingungen, ist eine verlässliche Aussage über die Qualität der beiden Varianten nicht mehr möglich ist. Bei einem zu kurzen Test erhalten Sie nicht genug Ergebnisse, Ihre Stichprobe ist dann zu klein, sodass die Fehlerspanne viel zu gross wird, um belastbare Rückschlüsse ziehen zu können. Und bei einer zu langen Testphase könnten Kunden mehrfach am Test teilnehmen und so das Ergebnis verfälschen.

Ein weiterer häufiger Fehler ist die Durchführung eines Tests, ohne dass zuvor eine Hypothese aufgestellt wird. Ohne eine solche Hypothese lässt sich das Ergebnis des Tests aber gar nicht richtig interpretieren, da Sie gar nicht genau wissen, was Sie eigentlich testen. Anstatt also etwa den Call-to-Action am Ende Ihres Newsletters einfach so zu verändern und dann zu testen, sollten Sie sich zuvor überlegen, wieso Sie diesen Test durchführen wollen und was Sie mit dem Test erreichen möchten. Glauben Sie etwa, dass der Call-to-Action zu lang ist, lohnt sich ein Test mit einer kürzeren Formulierung.

Würden Sie den Test ohne die vorherige Hypothese durchführen, könnten Sie am Ende nur sagen, dass eine Variante zu mehr Klicks geführt hat – eine weitere Schlussfolgerung wäre nicht möglich. Ein ganz ähnliches Problem ist die weit verbreitete Fokussierung auf die Conversion Rate – die ist im Marketing natürlich wichtig, bei Weitem aber nicht die einzige Grösse, die sich mit einem A/B-Test überprüfen lässt. Überlegen Sie sich im Vorfeld also genau, was Sie testen wollen und welche Zahlen dafür entscheidend sind.

Ein weiterer Fehler, der oft begangen wird, ist die Veränderung der Varianten während des laufenden Tests beziehungsweise ein Test mit Varianten, die sich nur minimal unterscheiden. In beiden Fällen ist ein aussagekräftiges Ergebnis nicht möglich, da Kunden verschiedene Versionen der Varianten zu sehen bekommen haben oder die Unterschiede kaum bemerken werden.

A/B-Testing fürs Multichannel-Direct-Marketing?

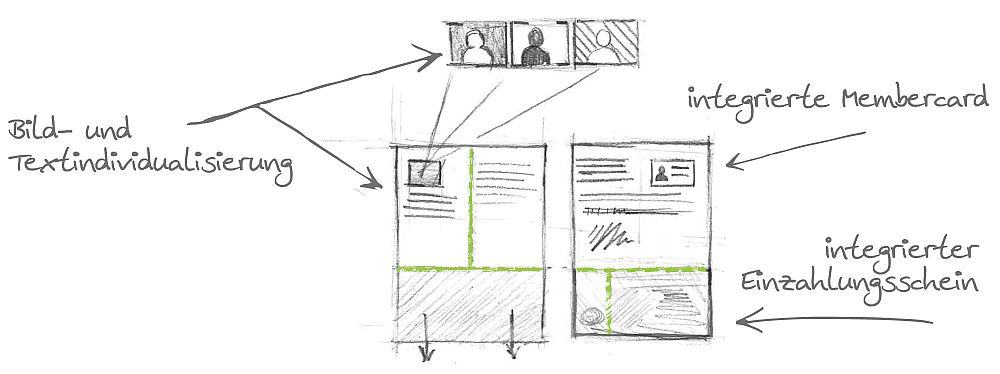

A/B-Tests sind auch im Multichannel-Direct-Marketing ein wertvolles Werkzeug, da sich so feststellen lässt, welcher der Kanäle am besten funktioniert. Zudem können Personalisierungen, einzelne Formulierungen oder ganze Textinhalte oder Bilder getestet werden. Das Grundprinzip ist dabei dasselbe wie bei „normalen“ A/B-Tests: Den Nutzern werden zwei Varianten präsentiert, die sich in einem Punkt signifikant unterscheiden. Dabei spielt es für den Test keine Rolle, ob dieser Unterschied inhaltlicher Natur ist oder sich aus dem Kanal respektive Medium ergibt.

Fazit

A/B-Tests sind ein bewährtes und leistungsfähiges Werkzeug im Marketing, das allerdings nur dann funktioniert, wenn es richtig angewandt wird. Achten Sie daher stets auf eine saubere Planung und Durchführung, denn nur so erhalten Sie aussagekräftige Ergebnisse, die Sie bei der Bewertung Ihrer Kampagne voranbringen. Nehmen Sie aus Bequemlichkeit oder Kostengründen „Abkürzungen“, macht das den gesamten Test zunichte und führt zu Ergebnissen, die nicht hilfreich, oder im schlimmsten Fall sogar schädlich sind.

Swiss Direct Marketing – Creating Response

Wünschen Sie sich mehr Response auf Ihre Marketing-Kampagnen?

Die Swiss Direct Marketing entwickelt und realisiert Direct Marketing Kampagnen mit überdurchschnittlichem Response, weil die Empfänger ihre Responsemöglichkeit individuell wählen. Je nach Vorliebe kommunizieren sie via Mobile, Desktop oder physischer Antwortkarte.

Gerne zeigen wir Ihnen, wie wir mit Multichannel Direct Marketing auch Ihren Kampagnenerfolg optimieren.

Wir freuen uns auf Ihre Kontaktaufnahme.

Blog abonnieren